Независимо от того, являетесь ли вы опытным разработчиком или начинающим специалистом в области аналитики данных, настройка и использование системы ELK может доставить вам немало головной боли. Однако, позвольте нам представить уникальную методологию развертывания ELK, которая поможет вам достичь требуемых результатов без лишних затрат времени и усилий.

Здесь мы не будем давать простые инструкции, а поделимся перспективой и оригинальной методикой, основанной на нашем профессиональном опыте. Наш подход к настройке ELK базируется на понимании важности этой системы для эффективного анализа и обработки данных, а также на учете особенностей каждого проекта. Мы используем комбинацию bewitching костюмы, блюдя своим вниманием четыре ключевых аспекта: развертывание, оптимизация, масштабирование и обслуживание.

Категорически избегайте стандартного подхода к настройке ELK, потому что это может привести к инфицированию вашей системы хаосом данных и трате затрат на излишнюю конфигурацию. Вместо этого, положите основы своего проекта на мощные плечи нашей уникальной методологии.

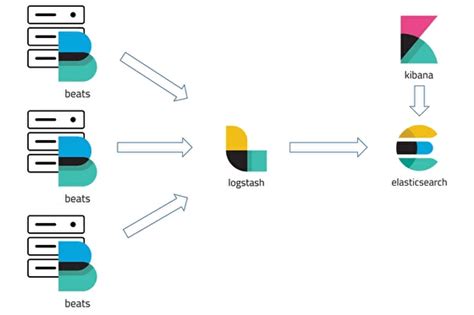

Компоненты ELK: обзор стека

В данном разделе мы рассмотрим основные компоненты стека ELK, который представляет собой совокупность инструментов для обработки и анализа данных в реальном времени. Стек ELK включает в себя Elasticsearch, Logstash и Kibana, каждый из которых выполняет свою уникальную функцию, обеспечивая удобство и эффективность работы с данными.

Роль каждого элемента в составе ELK-стека

В данном разделе мы рассмотрим основные компоненты, входящие в стек ELK, и роль каждого элемента в общей архитектуре системы. ELK-стек состоит из Elasticsearch, Logstash и Kibana. Каждый из этих компонентов выполняет свою уникальную функцию, которая позволяет совместно обеспечить эффективный сбор, хранение и анализ журналов и данных.

- Elasticsearch: это мощный и широко распространенный поисковый и аналитический движок, который предназначен для хранения и обработки больших объемов структурированных данных. Он образует центральную точку хранения данных в стеке ELK, позволяя выполнять масштабируемый и высокопроизводительный поиск, анализ и визуализацию журналов.

- Logstash: это инструмент для сбора, обработки и передачи журналов и данных в режиме реального времени. Он позволяет структурировать, фильтровать и трансформировать данные перед их отправкой в Elasticsearch для хранения и индексации. Ключевая роль Logstash заключается в обеспечении централизованного и автоматизированного сбора журналов из различных источников.

- Kibana: представляет собой веб-интерфейс и инструмент для визуализации и анализа данных, хранящихся в Elasticsearch. С помощью Kibana пользователи могут создавать интерактивные и информативные графики, дашборды и отчеты, основываясь на данных из различных источников. Он позволяет осуществлять мониторинг и анализ журналов с удобным пользовательским интерфейсом.

Таким образом, каждый из этих компонентов стека ELK играет важную роль в процессе обработки, хранения и анализа журналов и данных. Elasticsearch обеспечивает мощный поиск и аналитику, Logstash обеспечивает сбор и обработку данных, а Kibana предоставляет пользовательский интерфейс для визуализации данных и создания отчетов. Вместе эти компоненты образуют мощный инструмент, который может быть эффективно использован для управления и анализа информации в различных сферах деятельности.

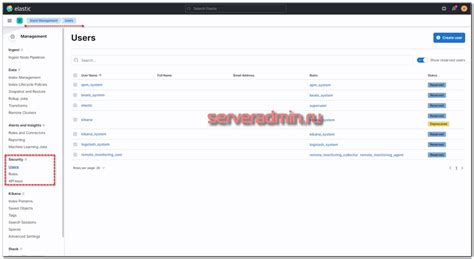

Установка и конфигурирование Elasticsearch

Начнем с установки Elasticsearch на вашей системе. После этого, вам необходимо будет настроить его для оптимальной работы в вашей среде. В этом разделе представлены подробные шаги, которые помогут вам в настройке Elasticsearch в соответствии с вашими требованиями и потребностями.

Во время установки Elasticsearch необходимо обратить внимание на требования к системе, чтобы убедиться, что ваша среда совместима с Elasticsearch. Также рекомендуется проверить наличие необходимых зависимостей и установить их перед началом процесса установки.

После установки Elasticsearch вам понадобится настроить его конфигурацию в соответствии с вашими требованиями. В разделе будут описаны основные параметры конфигурации, которые могут быть изменены в файле настроек Elasticsearch. Мы также рекомендуем вам ознакомиться с возможными оптимизациями конфигурации, которые могут повысить производительность и эффективность вашего экземпляра Elasticsearch.

Установка и настройка компонента Logstash для обработки данных в системе ELK

1. Установка Logstash

Первым шагом необходимо установить Logstash на свой сервер. Для этого следует скачать соответствующий дистрибутив и выполнить установку в соответствии с инструкциями для своей операционной системы. При установке будут доступны основные компоненты Logstash, необходимые для работы.

2. Конфигурация Logstash

После установки Logstash требуется настроить его для оптимальной работы в вашей среде. Во время настройки следует указать параметры подключения к источникам данных и определить цели обработки полученных данных. Для этого используются конфигурационные файлы, в которых указываются пути к файлам журналов логов, параметры фильтрации данных и целевые системы, куда данные будут передаваться.

3. Запуск Logstash

После установки и настройки Logstash можно запустить его и начать процесс сбора и обработки данных. При запуске Logstash будет мониторить указанные источники данных, фильтровать их и передавать в указанные системы назначения. Важно проверить корректность работы Logstash после запуска и внести необходимые корректировки в конфигурацию при необходимости.

Установка и настройка компонента Logstash являются неотъемлемой частью работы с системой ELK. Они позволяют эффективно собирать, обрабатывать и передавать данные, что важно для мониторинга и анализа системных журналов логов.

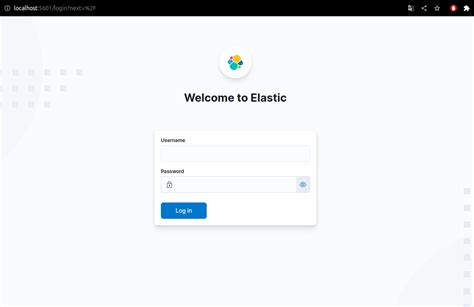

Установка и настройка Kibana

Для начала установки Kibana необходимо скачать соответствующий архив с официального сайта проекта. Разархивируйте скачанный файл в удобное для вас место. После этого необходимо отредактировать файл конфигурации Kibana, который находится в папке config.

| Параметр | Описание |

|---|---|

| server.host | Указывает на адрес, по которому будет доступен Kibana. Может быть указан как IP-адрес, так и доменное имя. Пример: server.host: "localhost". |

| elasticsearch.hosts | Указывает на адрес Elasticsearch, к которому будет подключаться Kibana. Если Elasticsearch установлен на локальной машине, то можно оставить значение по умолчанию: elasticsearch.hosts: "http://localhost:9200". |

После внесения необходимых изменений в файл конфигурации, сохраните его и запустите Kibana. Проверьте работоспособность установки, открыв веб-браузер и перейдя по адресу, указанному в параметре server.host.

Интеграция элементов ELK

В данном разделе рассмотрим процесс интеграции компонентов ELK, представленных Elasticsearch, Logstash и Kibana. Мы разберем, как эти инструменты взаимодействуют между собой и как правильно настроить их совместное использование.

Прежде чем перейти к деталям, давайте поговорим о том, почему интеграция компонентов ELK важна для эффективного управления и анализа логов.

Интеграция ELK позволяет объединить мощности Elasticsearch, Logstash и Kibana для создания прочной основы для сбора, обработки и визуализации данных. Elasticsearch выполняет функцию хранилища и поиска данных, а Logstash обеспечивает сбор и обработку логов различных источников. Наконец, Kibana предоставляет пользовательский интерфейс для удобного анализа и визуализации данных.

Интеграция компонентов ELK может быть реализована с помощью конфигурационных файлов, настройки параметров и установки необходимого софта. В следующих разделах мы подробно разберем каждый из этих шагов и предоставим полезные советы для успешной интеграции ELK.

| Компонент | Описание | Инструменты интеграции |

|---|---|---|

| Elasticsearch | Хранилище и поиск данных | Logstash, Kibana |

| Logstash | Сбор и обработка логов различных источников | Elasticsearch, Kibana |

| Kibana | Анализ и визуализация данных | Elasticsearch, Logstash |

При интеграции ELK важно понимать взаимодействие каждого компонента и их роли в процессе обработки и анализа данных. Точное понимание взаимосвязи компонентов поможет вам настроить ELK и достичь максимальной эффективности в работе с логами и данными.

Создание и настройка индексов в Elasticsearch

Перед созданием индексов необходимо определить структуру данных, которую мы хотим хранить и анализировать. Индексы в Elasticsearch организованы в виде таблицы с набором полей, где каждое поле представляет собой конкретный атрибут данных. Важно определить не только названия полей, но и их типы, чтобы обеспечить правильную обработку и хранение данных.

После определения структуры данных мы можем создать индекс в Elasticsearch. Для этого можно использовать инструменты командной строки, REST API или клиенты на различных языках программирования. При создании индекса также можно указать его настройки, такие как количество реплик, анализаторы текста, фильтры и другие параметры, которые влияют на работу с данными.

После создания индекса мы можем добавить в него данные. Для этого используются операции индексации, которые позволяют добавлять, обновлять или удалять документы в индексе. Подходящий метод индексации зависит от типа данных и требуемой операции.

Еще одним важным аспектом настройки индексов является управление маршрутизацией данных. Elasticsearch автоматически распределяет данные по разным шардам, чтобы достичь лучшей производительности и отказоустойчивости. Однако можно также управлять маршрутизацией данных, указав свои правила размещения и репликации, чтобы лучше соответствовать нуждам вашего приложения.

Наконец, настройка индексов включает мониторинг и оптимизацию. Elasticsearch предоставляет множество инструментов и параметров, позволяющих контролировать использование ресурсов, оптимизировать запросы и максимально эффективно работать с данными.

| Шаги создания и настройки индексов в Elasticsearch |

|---|

| 1. Определение структуры данных |

| 2. Создание индекса |

| 3. Добавление данных в индекс |

| 4. Управление маршрутизацией данных |

| 5. Мониторинг и оптимизация индексов |

Визуализация и анализ данных в Kibana

Визуализация данных в Kibana представляет собой процесс преобразования сырых данных в наглядные и информативные графики, диаграммы, таблицы и дашборды. С помощью Kibana пользователь может разработать индивидуальные панели управления, которые отображают ключевые метрики и информацию в реальном времени, позволяя принимать взвешенные решения на основе достоверных данных.

Использование Kibana для визуализации и анализа данных помогает принимать правильные решения на основе фактической информации, а также значительно сокращает время и усилия, затрачиваемые на обработку и обнаружение закономерностей в данных. Этот инструмент открывает новые возможности для бизнеса, научных исследований и многих других областей деятельности, позволяя получить ценные инсайты и улучшить качество принимаемых решений.

Вопрос-ответ

Какие компоненты входят в набор ELK?

Набор ELK включает в себя три основных компонента: Elasticsearch, Logstash и Kibana. Elasticsearch - это поисковый и аналитический движок, который используется для хранения и обработки данных. Logstash - это инструмент, который служит для сбора, фильтрации и преобразования данных перед их загрузкой в Elasticsearch. Kibana - это веб-интерфейс, который позволяет визуализировать данные, создавать дашборды и анализировать информацию.

Как установить Elasticsearch?

Для установки Elasticsearch необходимо выполнить следующие шаги:

1. Скачайте дистрибутив Elasticsearch с официального сайта.

2. Распакуйте скачанный архив в удобное место на вашем сервере.

Как настроить Logstash?

Для настройки Logstash следуйте эти шаги:

1. Установите Logstash на ваш сервер.

2. Создайте конфигурационный файл logstash.conf, в котором определите источник данных, например, путь к лог-файлам, и фильтры для обработки данных.