В мире современных технологий все большую роль играют инструменты, позволяющие эффективно автоматизировать повседневные задачи. Они помогают сэкономить время и ресурсы, улучшить процессы и повысить продуктивность. В этом отношении Apache Airflow является одним из самых мощных и гибких инструментов.

Apache Airflow - это фреймворк с открытым исходным кодом, предназначенный для создания, планирования и управления рабочими процессами. Он предоставляет удобные возможности для автоматизации задач в различных сферах деятельности - от обработки данных и научных исследований до развертывания приложений и мониторинга систем.

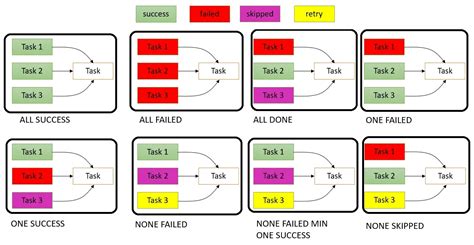

Главной особенностью Apache Airflow является его модульная архитектура, которая позволяет легко создавать и настраивать сложные рабочие потоки путем комбинирования простых задач. Он основан на понятии "DAG (Directed Acyclic Graph)", которое представляет собой граф зависимостей между задачами. Это позволяет создавать сложные сценарии выполнения задач, задавать порядок их выполнения, контролировать завершение и перезапускать задачи при необходимости.

Введение в Apache Airflow: функциональность и применение в проектах

Возможности Apache Airflow включают в себя понятие дагов (DAGs), что означает направленный ациклический граф задач. Это позволяет определить зависимости между задачами и управлять их выполнением в соответствии с определенной логикой и временными параметрами. Гибкость Airflow позволяет легко добавлять, изменять или удалять задачи и зависимости в рабочем процессе без необходимости перезапуска всей системы.

Для использования Apache Airflow в вашем проекте, необходимо сначала настроить его окружение. В этом процессе вы создадите и определите свои первые даги, которые представляют собой набор задач, исполняемых последовательно или параллельно. Внутри каждой задачи вы можете использовать различные операторы, которые позволяют выполнять различные операции, такие как выполнение SQL-запроса, запуск командной строки или вызов HTTP-запроса.

Apache Airflow также предоставляет механизм планирования и мониторинга задач. Вы можете настроить расписание выполнения ваших дагов, учитывая условия запуска, временные интервалы, зависимости и другие параметры. Механизм мониторинга позволяет отслеживать выполнение задач, получать уведомления об ошибках и событиях, а также анализировать результаты выполнения задач для дальнейшей оптимизации процесса.

Использование Apache Airflow в вашем проекте может значительно упростить и автоматизировать рабочий процесс, улучшить его отслеживаемость и обеспечить стабильное выполнение задач. Благодаря его гибкости и функциональности, Airflow является надежным инструментом для управления вашими проектами, независимо от их сложности и масштаба.

Основные концепции и принципы функционирования

- Декларативный подход: Airflow предлагает декларативный подход к определению рабочих нагрузок и зависимостей между ними. Вместо программирования каждой задачи отдельно, пользователи могут описывать задачи и их зависимости с использованием общих концепций и шаблонов, что сокращает время разработки и упрощает поддержку процессов.

- DAG (Directed Acyclic Graph): Airflow использует концепцию направленного ациклического графа (DAG) для моделирования сложных процессов выполнения задач. DAG состоит из узлов (задач) и направленных ребер (зависимостей), которые определяют порядок выполнения задач. Каждая задача в DAG может зависеть от других задач и порядок их выполнения может быть четко определен.

- Сенсоры: В Airflow сенсоры используются для проверки условий перед выполнением задач. Сенсоры мониторят внешние источники или состояние системы и ждут до тех пор, пока не будут выполнены определенные условия, прежде чем запускать следующую задачу. Это позволяет более гибко контролировать поток выполнения и увеличивает надежность процессов.

- Операторы: Операторы представляют собой атомарные задачи, выполняющие конкретные действия. Airflow предоставляет множество встроенных операторов для различных типов задач, таких как выполнение SQL-запросов, запуск Docker-контейнеров и отправка электронных писем. Пользователи также могут создавать собственные операторы для выполнения специфических задач.

- Планировщик: Airflow имеет встроенный механизм планирования задач, который определяет, когда и как выполнять каждую задачу в DAG. Планировщик учитывает зависимости между задачами, распределяет ресурсы и обеспечивает выполнение задач с учетом приоритетов и расписания.

Понимание этих основных концепций и принципов поможет вам более эффективно использовать Apache Airflow для автоматизации и управления вашими рабочими процессами. Разделы дальнейшего руководства углубят ваше понимание каждой из этих концепций и предоставят детальные инструкции по их использованию.

Настройка и установка Apache Airflow на вашем сервере

1. Подготовка сервера:

Прежде чем установить Apache Airflow, убедитесь, что ваш сервер имеет все необходимые предустановленные компоненты, такие как Python, Docker, PostgreSQL и т.д. Проверьте обновления и установите все необходимые пакеты для поддержки Apache Airflow.

2. Установка Python и зависимостей:

Установите последнюю версию Python на вашем сервере и убедитесь, что у вас установлены необходимые зависимости, такие как pip, virtualenv и т.д. Создайте виртуальное окружение для работы с Apache Airflow и активируйте его.

3. Установка Apache Airflow:

Теперь, когда ваше окружение настроено и все зависимости установлены, вы можете установить Apache Airflow с помощью команды установки pip. Убедитесь, что вы устанавливаете последнюю версию Apache Airflow и указываете все необходимые параметры, такие как конфигурация базы данных, плагины и т.д.

4. Настройка и запуск Apache Airflow:

После установки Apache Airflow вам необходимо настроить его для вашего сервера. Это включает в себя настройку параметров конфигурации, определение подключения к базе данных, установку плагинов и т.д. После настройки, вы можете запустить Apache Airflow и начать его использование.

5. Тестирование и отладка:

После запуска Apache Airflow рекомендуется протестировать его работу и провести отладку, чтобы убедиться, что все работает должным образом. Вы можете создать простые задачи и расписания, чтобы убедиться, что Apache Airflow работает в соответствии с вашими ожиданиями.

Следуя этому руководству, вы сможете успешно настроить и установить Apache Airflow на вашем сервере. Не забывайте обновлять и поддерживать свою установку Apache Airflow, чтобы использовать все последние функции и исправления.

Установка и настройка Apache Airflow

Этот раздел предоставляет подробное руководство по шагам, которые необходимо выполнить для успешной установки и конфигурации Apache Airflow на вашей системе. Здесь вы найдете все необходимые инструкции и советы для настройки этого мощного инструмента синхронизации и мониторинга задач и рабочих процессов.

Шаг 1: Подготовка окружения

Перед установкой Apache Airflow необходимо убедиться, что ваше окружение полностью подготовлено и соответствует требованиям данного инструмента. Это включает проверку версии Python, установку необходимых зависимостей и настройку базы данных.

Шаг 2: Установка Apache Airflow

Второй шаг - это установка самого Apache Airflow с использованием предоставленных инструкций. Вы узнаете, как установить Airflow с помощью pip, создать и активировать виртуальное окружение, а также выполнить другие необходимые действия для успешной установки пакета.

Шаг 3: Конфигурация Apache Airflow

После установки необходимо правильно настроить Apache Airflow с учетом ваших потребностей и требований. В этом разделе вы найдете рекомендации по настройке различных компонентов Airflow, включая конфигурацию базы данных, хранилища, аутентификации и других важных параметров.

Шаг 4: Запуск и мониторинг задач

После успешной установки и конфигурации вы будете готовы к запуску и мониторингу своих задач с помощью Apache Airflow. В этом разделе вы узнаете, как создавать и планировать задачи, настраивать рабочие процессы и осуществлять мониторинг через веб-интерфейс Airflow.

Следуя этим шагам, вы сможете эффективно установить и настроить Apache Airflow для управления своими рабочими процессами и задачами. Не стесняйтесь обращаться к этому руководству для получения необходимой помощи и советов по использованию данного мощного инструмента.

Приемы и хитрости при работе с Apache Airflow

Этот раздел представляет собой набор полезных советов, трюков и приемов, которые помогут вам эффективно работать с Apache Airflow. Здесь вы найдете разнообразные strategies для достижения оптимальной производительности, улучшения надежности и упрощения процесса работы.

1. Максимально используйте возможности технологии Apache Airflow для улучшения производительности вашего рабочего процесса. Используйте слои и механизмы планировщика для эффективной организации параллельного выполнения задач и оптимизации расходов ресурсов.

2. Один из важных аспектов работы с Apache Airflow - это эффективное управление конфигурацией. Используйте переменные среды и файлы конфигурации для настройки параметров и поведения ваших задач, упрощая тем самым их масштабирование и переиспользование.

3. В работе с Apache Airflow полезно использовать различные типы дат, временных интервалов и планировщиков. Это позволяет гибко настраивать частоту выполнения задач и определять их зависимости от других задач в рамках рабочего процесса.

4. Для эффективного запуска задач вам может потребоваться определить стратегии пакетной передачи данных, такие как использование Apache Kafka или Apache Spark. Такой подход позволяет снизить время выполнения и обеспечить безопасную передачу данных между задачами.

5. В Apache Airflow предусмотрены разнообразные механизмы мониторинга и отладки задач. Используйте их для отслеживания хода выполнения задач, обнаружения ошибок и улучшения производительности вашего рабочего процесса.

6. Используйте возможности расширения Apache Airflow, такие как создание собственных операторов, датчиков и подключаемых модулей. Это позволит вам создавать уникальные и гибкие рабочие процессы, отвечающие специфическим требованиям вашего проекта.

| Полезные советы: | Примеры трюков: |

|---|---|

| Используйте наследование операторов для повторного использования кода | Напишите автоматические тесты для ваших задач перед развертыванием |

| Оптимизируйте процесс обновления DAG-ов при изменении кода | Используйте язык SQL для более сложных операций с данными |

| Настройте алерты для операторов, чтобы получать уведомления об их выполнении | Используйте шаблоны Jinja для динамической генерации параметров задач |

Вопрос-ответ

Что такое Apache Airflow и для чего его используют?

Apache Airflow - это открытая платформа для управления и планирования рабочих процессов (workflows) в комплексных системах обработки данных. Она позволяет программистам определить, расписать и запустить последовательность задач, которые должны быть выполнены в определенном порядке или по определенному расписанию. Airflow используется для автоматизации ETL процессов (извлечение, трансформация, загрузка) данных, выполнения расписаний задач и создания рабочих процессов различной сложности.

Как установить и настроить Apache Airflow?

Установка и настройка Apache Airflow может быть сложным процессом. Однако, основные шаги включают установку Python, установку Airflow с помощью инструмента управления пакетами (например, pip), создание базы данных для хранения метаданных Airflow, настройку конфигурационных файлов и запуск Airflow web-сервера. Подробные инструкции по установке и настройке можно найти в документации Apache Airflow или в специальных руководствах.

Как добавить новую задачу в рабочий процесс Apache Airflow?

Для добавления новой задачи в рабочий процесс Apache Airflow необходимо создать новый Python скрипт, определить класс PythonOperator или BashOperator (в зависимости от типа задачи), определить логику задачи и задать зависимости (если нужно). Затем, скрипт с задачей должен быть добавлен в директорию с дагами (планами выполнения задач), после чего Airflow обнаружит новую задачу и регулярно будет проверять и выполнять ее в соответствии с заданным расписанием.